前沿技术部分知识点

都是PPT上的原话,概念的东西,不全,也不知道考不考

1.人工智能的定义(无官方统一定义)

1 | |

2.AI研究目的

•人工智能研究目的是通过探索智慧的实质,扩展人类智能——促使智能主体会听(语音识别、机器翻译等)、会看(图像识别、文字识别等)、会说(语音合成、人机对话等)、会思考(人机对弈、专家系统等)、会学习(知识表示,机器学习等)、会行动(机器人、自动驾驶汽车等)。

3.AI学派

联结主义,符号主义(两大主要主义),行为主义

联结主义:利用数学模型来研究人类认识的方法,用神经元的连接机制实现人工智能

- 代表方法:神经网络,SVM

符号主义:认知是通过对有意义的表示符号进行推导计算,并将学习视为逆向演绎,主张用显式的公理和逻辑体系搭建人工智能系统

- 代表方法:专家系统,知识图谱

行为主义:以控制论及感知-动作型控制系统原理模拟行为以复现人类智能

- 代表方法:强化学习

4.人工智能三要素

数据,算力,算法

5.算法

- 传统机器学习算法:BP算法,SVM(支持向量机),Boosting,Logistic Regression

- 深度学习:MLP,CNN,RNN,LSTM

6.机器学习定义

1 | |

7.机器学习类型

- 监督

- 无监督

- 半监督

- 强化

8.常用激活函数

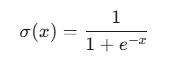

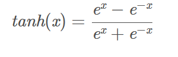

- Sigmoid

缺点:1.会造成梯度消失;2.输出不以0为中心(总是正值)可能导致下一层神经元的权重梯度方向单一,从而减缓训练收敛

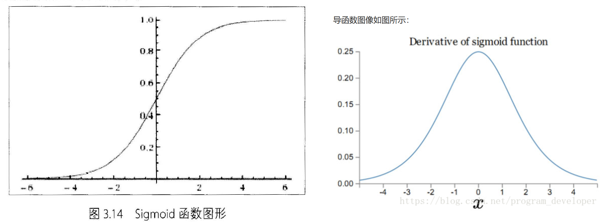

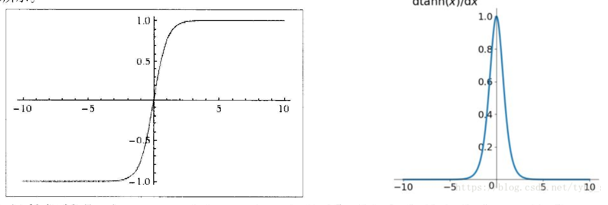

Tanh

缺点:梯度消失

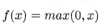

ReLU

1.优点:①极大地加速随机梯度下降法的收敛速度,并且因为是线性的,所有没有 梯度消失的问题

②计算方法更简单

2.缺点:当神经元输入为负导致其梯度持续为0时,该神经元将停止更新并“死亡”, 这可以通过使用较小的学习率来缓解。

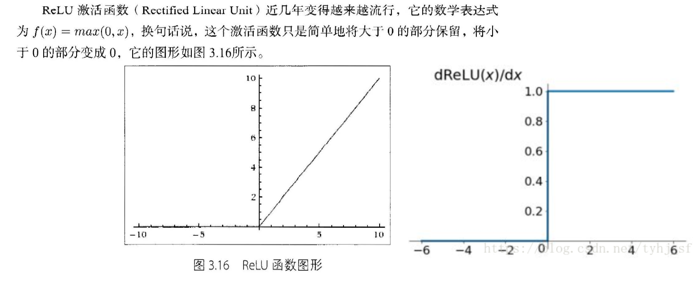

ELU(不重要)

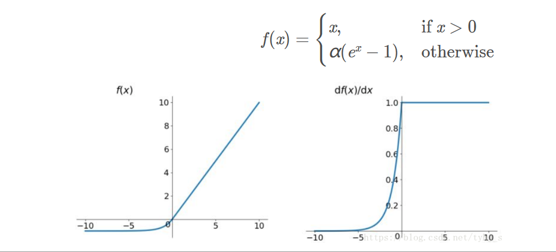

Leaky ReLU(不重要)

9.损失函数

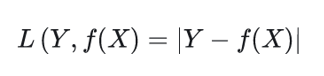

①回归问题

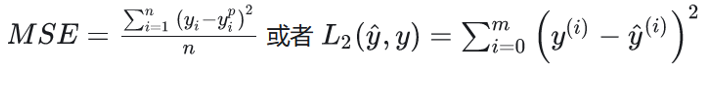

MSE均方误差

优点:各点连续光滑,方便求导,具有稳定的解

缺点:不稳健,输入值距中心点较远时,用梯度下降法求解梯度会很大,可能梯度爆炸

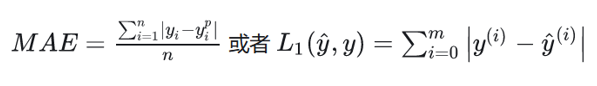

平均绝对误差

优点:任何输入都有稳定梯度,不会梯度爆炸,有稳定的解

缺点:中心点是折点,无法求导

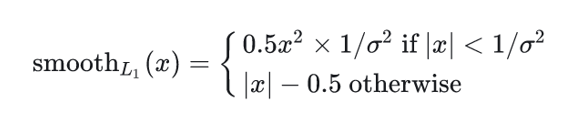

smooth L1 loss

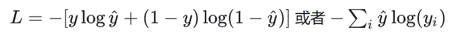

②分类问题

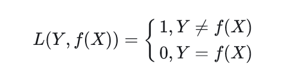

0-1损失函数

绝对值损失函数

- 交叉熵损失函数

其他、

10.深度模型优化

- 经验风险最小化

- 批量算法

- 随机梯度下降

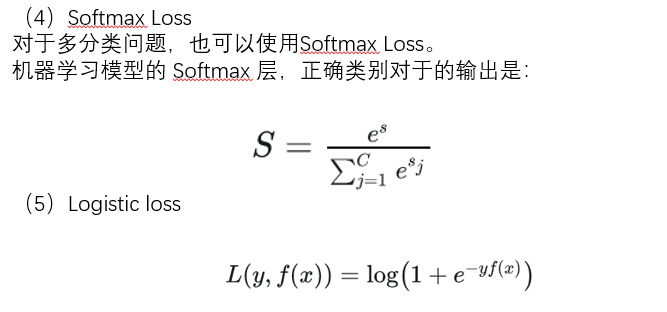

11.卷积神经网络

至少在网络的一层中使用卷积运算来替代一般的矩阵乘法运算的神经网络

用于更好的处理图像问题(如人脸识别)

12.卷积神经网路拓展

VGGNet

GoogLeNet

ResNet

13.循环神经网络(RNN)

14.前馈网络不足

1 | |

15.RNN存在的问题

- 有遗忘性

- 对于依赖近期信息的任务有良好的预测结果,而对依赖长时间信息的任务表现不好(例如梯度爆炸或梯度消失)

16.长期依赖问题

循环神经网络在时间维度上非常深(梯度消失)

改进:循环边改为线性依赖关系,或者增加非线性

17.LSTM

能处理长时间依赖的问题,但本质还是解决短时记忆问题的方法

- 步骤

- Step1:决定丢弃信息

- Step2:确定存放在细胞状态中的新信息

- Step3:更新细胞状态

- Step4:基于细胞状态得到输出

18.自编码器

是神经网络的一种,经过训练后能尝试将输入复制到输出

传统自编码器被用于降维或特征学习,今年与潜变量模型理论联系走向了生成式建模的道路

19.生成对抗网络

两大模型:生成模型,对抗模型

20.降维

减少描述数据的特征数量的过程(一般方法为选择或提取)

21.表示学习

通过在辅助监督学习任务上训练神经网络,从未标记的数据中提取特征

word2vec是表示学习界的“Hello World”应用

22.统计学领域两大学派

频率学派与贝叶斯学派(两者对未知参数的推断和估计有截然不同的观点)

- 频率学派:基于大样本理论,把概率看作频率的极限,通过信心来推断总体参数,过程客观可重复

- 贝叶斯学派:任何未知量都是随机的,应该用概率分布去描述

23.隐变量模型用于在网络模型上模拟世界上的客观存在

24.用KL散度度量两个分布之间的差距,最大似然估计让人造分布与真实分布更接近

25.常见深度学习框架

PyTorch,Theano,Keras,TensorFlow,Caffe等

PyTorch,Theano,Keras基于Python,Caffe基于C++

26.强化学习特征:奖励延迟,行为序列学习,动态互动

27.知识图谱本质是为了表示知识

28.知识图谱定义(无官方定义,下列定义为参考)

有一些相互连接的实体和他们的属性构成的(即一条条知识组成,每条知识表示为一个SPO三元组)

ps:SPO=Subject,Predicate,Object

29.常见知识图谱项目

- Cyc

- WordNet

- ConceptNet

- Wikidata

- OpenKG.CN(Chinese)

30.知识图谱技术

- 知识表示,知识问答,语义搜索,知识链接,知识推理等

31.什么是知识表示

研究怎样用计算机符号来表示人脑中的知识,以及怎样通过符号之间的运算来模拟人脑推理过程

32.知识图谱分布式表示

在保留语义的同时,将知识图谱中的实体和关系映射到连续的稠密的低维的向量空间

33.知识融合案例

- 医疗健康

- 金融

- 电商

- 农业